Robots文件的作用及其对网站优化的重要性(通过管理Robots文件实现网站的优化)

![]() 游客

2024-07-13 16:28:02

53

游客

2024-07-13 16:28:02

53

在互联网时代,每个网站都需要做好自身的优化工作才能获得更多的流量和更好的用户体验。而Robots文件,作为网站优化中不可或缺的一个环节,可以帮助我们更好地控制和管理搜索引擎爬虫的访问行为,从而达到更好的网站优化效果。

一、Robots文件的定义及其作用

Robots文件是指一个文本文件,它位于网站的根目录下,用来指示搜索引擎爬虫在访问网站时应该如何进行行为控制。该文件中包含了一些指令,告诉搜索引擎哪些页面可以被访问,哪些页面不可以被访问,以及搜索引擎访问网站的频率等。

二、Robots文件对搜索引擎收录的影响

Robots文件对搜索引擎收录的影响非常大,通过Robots文件中的指令,我们可以控制搜索引擎爬虫对我们网站内容的抓取和索引。如果我们希望某些页面不被搜索引擎收录,或者希望搜索引擎增加访问频率来更快地更新我们的网站内容,都可以通过Robots文件来实现。

三、Robots文件中的指令

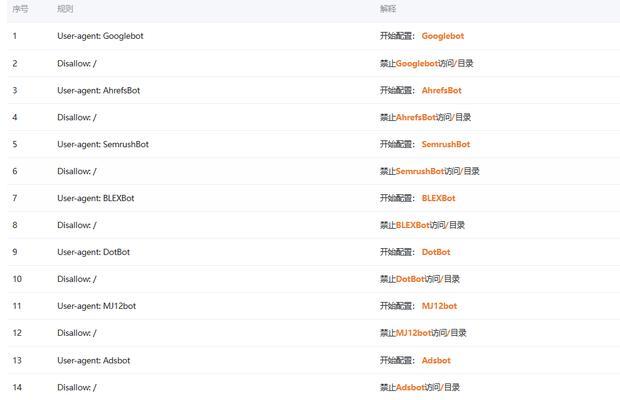

Robots文件中有很多指令,比如Disallow、User-agent、Crawl-delay等。其中最常用的是Disallow指令,它用于指示搜索引擎哪些页面不应该被访问和收录。User-agent指令用于告诉搜索引擎哪些爬虫可以访问我们的网站,而Crawl-delay指令则用于控制搜索引擎爬虫的访问速度。

四、Robots文件的编写规范

在编写Robots文件时,需要遵守一些规范。比如每个指令都需要独立一行,需要区分大小写,不能添加注释,且必须保证正确性和完整性。如果Robots文件编写不规范,可能会对网站优化产生负面影响。

五、Robots文件和Sitemap.xml文件的关系

Sitemap.xml文件是用来向搜索引擎提交网站地图信息的文件,而Robots文件则用来控制搜索引擎爬虫访问行为。两者之间没有直接的关系,但是我们可以通过在Robots文件中指定Sitemap.xml文件的位置来帮助搜索引擎更好地抓取和索引我们的网站内容。

六、Robots文件对SEO优化的影响

通过合理地控制Robots文件中的指令,我们可以更好地控制搜索引擎爬虫的访问行为,从而提升网站在搜索引擎中的排名。同时,还可以避免一些误收录或者重复收录问题,为网站SEO优化提供更好的保障。

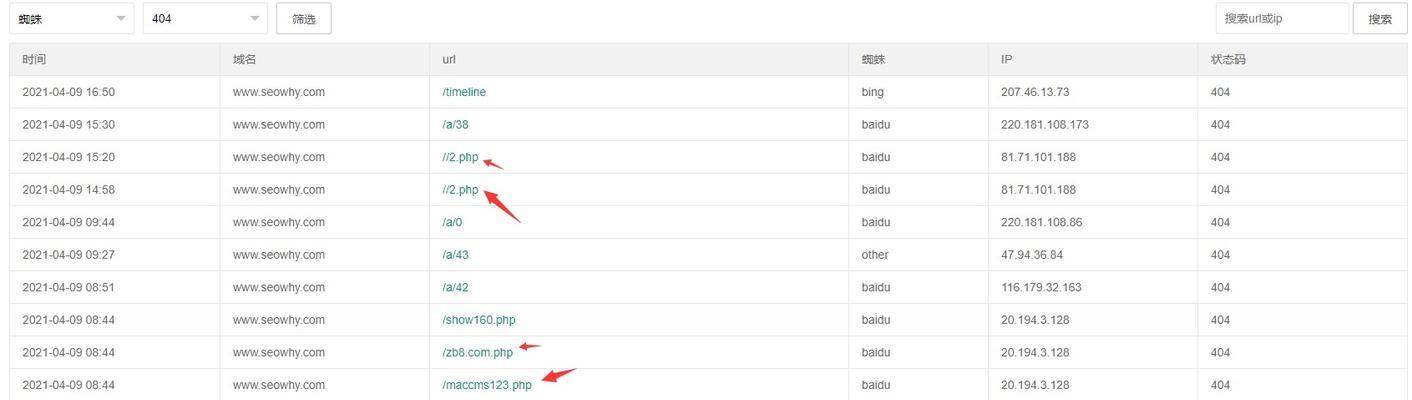

七、常见Robots文件错误及其解决方法

在Robots文件编写过程中,常常会出现一些错误,比如指令书写错误、路径设置错误等。这些错误可能会导致搜索引擎爬虫无法正确地抓取和索引我们的网站内容,因此需要及时排除这些错误。解决方法包括检查Robots文件语法是否正确、检查路径设置是否准确等。

八、

综上所述,Robots文件对网站优化有着重要作用。通过合理地管理和控制Robots文件中的指令,我们可以更好地掌握搜索引擎爬虫的访问行为,提升网站在搜索引擎中的排名和权重。同时,在编写Robots文件时需要注意规范和正确性,避免出现错误影响SEO优化效果。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自火星seo,本文标题:《Robots文件的作用及其对网站优化的重要性(通过管理Robots文件实现网站的优化)》

标签:

- 搜索

- 最新文章

- 热门文章

-

- 搜索引擎原理是什么?

- 什么是搜索引擎营销?搜索引擎营销有哪些优势?

- seo排名优化系统如何使用?如何通过系统提升网站排名?

- 网站模板源码如何选择?

- 设计网站建设如何兼顾美观与seo?

- 外贸网站开发的常见问题是什么?

- 怎样提升百度关键词搜索引擎排名?

- h5网站制作平台的优势是什么?

- 如何解决网站转化率低的问题?提高转化率的有效策略是什么?

- 金花关键词工具好用吗?如何有效利用金花关键词工具?

- 流程图在线制作网站如何操作?有哪些功能特点?

- 网站制作设计流程是怎样的?

- 专业网站制作服务的优势在哪里?

- 专业网站建设首选的标准是什么?如何选择最佳网站建设方案?

- SEO关键词优化的技巧有哪些?如何进行关键词分析?

- 网站制作中如何选择合适的域名?域名对SEO的影响是什么?

- SEO教学哪里找?有哪些免费资源可以利用?

- 相关关键词如何寻找?如何利用相关关键词提高网站流量?

- 无锡网站设计哪家公司好?如何选择无锡网站设计公司?

- 河北网站seo优化效果如何?常见问题解答?

- 热门tag