百度蜘蛛抓取页面的流程(深入了解蜘蛛爬虫的工作方式)

![]() 游客

2024-02-11 09:56:02

165

游客

2024-02-11 09:56:02

165

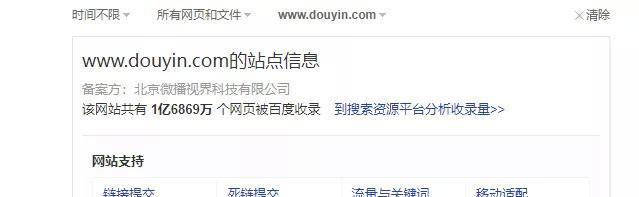

其中网站的排名关键因素就是搜索引擎的收录,在当前互联网时代,越来越多的企业或个人将自己的产品或服务推广至互联网平台上。其收录机制更是备受关注,而百度作为中国的搜索引擎之一。深入介绍其抓取页面的流程和工作方式、本文将从百度蜘蛛的角度出发。

一:蜘蛛爬行路径的规划和执行

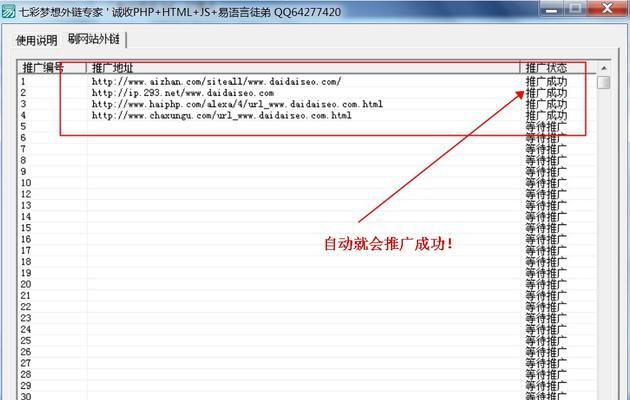

一般而言,然后通过页面中的链接逐一深入抓取网站中的各个页面,百度蜘蛛是从网站的首页开始爬行,蜘蛛爬行路径是指通过爬行某个链接后所形成的路径。还需要保证能够覆盖到网站中所有页面,其爬行路径不仅要考虑到页面之间的链接关系。以保证爬虫能够尽可能地抓取到所有页面,在执行爬行任务前需要进行路径规划。

二:网页内容的解析和分析

标签等信息进行处理,并根据其中的关键字,当百度蜘蛛爬行到某个页面时、会对该页面中的内容进行解析和分析。关键字等元素来判断该页面的主题和内容相关度,描述,百度蜘蛛会通过分析页面中的标题,在此过程中、并根据其结果对该页面进行评价。

三:网页内容更新机制的处理

并且会优先抓取更新频率较高的网页,百度蜘蛛会定期抓取已收录网页,为了保证搜索结果的准确性和及时性。百度蜘蛛会降低其抓取频率或者将其排除在外、对于更新频率较低或者很久未更新的网页。

四:反爬机制的应对策略

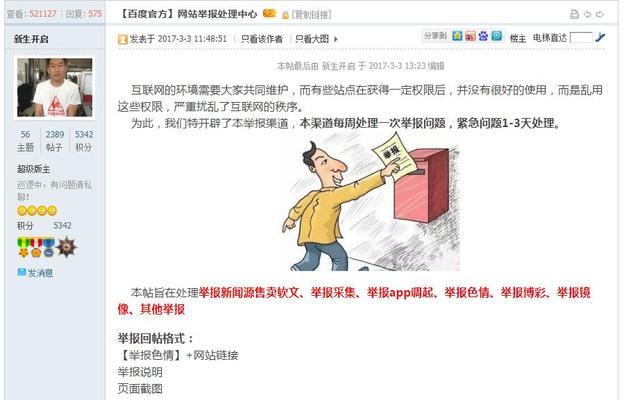

百度采用了多种反爬机制来防范爬虫攻击,为了防止恶意爬虫对其搜索引擎产生影响。以保证正常抓取页面,而百度蜘蛛作为一种合法的爬虫,需要针对这些反爬机制进行相应的应对策略。

五:去重算法的应用

百度蜘蛛需要保证每个页面仅被抓取一次、在抓取页面时,避免出现重复抓取和浪费资源。并通过计算网页内容的hash值和指纹信息等数据进行去重处理、为了实现去重功能,百度采用了一系列去重算法。

六:超链接深度和频率控制

百度蜘蛛会针对每个链接设置特定的访问深度和频率限制、过多流量等问题,为了避免因对某个链接进行过多访问而造成服务器资源浪费。并且能够使得抓取任务更加完成、这些限制不仅能够保证服务器资源有效利用。

七:JavaScript渲染页和AJAX请求处理

越来越多的网页采用JavaScript和AJAX等技术来实现交互效果,随着Web2,0时代的到来。而这些技术会对百度蜘蛛产生很大影响。百度蜘蛛需要进行相应的优化处理、为了正常抓取这些渲染页和处理AJAX请求的网页。

八:结果汇总和数据处理

整理,处理等操作,需要对所有得到的数据进行汇总、当百度蜘蛛完成所有抓取任务后、并根据相关算法计算每个页面的权重值和排名值。并直接影响网站在搜索引擎中的排名,这些数据会被用于百度搜索结果展示中。

在抓取过程中需要考虑到很多因素,百度蜘蛛作为一个自动抓取网页并将其数据提供给百度搜索引擎处理的程序、并进行相应处理、通过本文我们可以看到。才能更好地优化自己网站,只有深入了解其工作方式,提高排名和曝光率。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自火星seo,本文标题:《百度蜘蛛抓取页面的流程(深入了解蜘蛛爬虫的工作方式)》

标签:百度蜘蛛

- 搜索

- 最新文章

- 热门文章

-

- SEO关键词优化有哪些经验技巧?

- 关于网站的建设需要注意哪些问题?如何建设一个成功的网站?

- 关键词优化的常见误区有哪些?

- 长尾关键词的常见问题是什么?如何解决?

- 网站怎么做才能提高搜索引擎排名?SEO优化的关键步骤是什么?

- 淘宝关键词的优化作用有哪些?如何通过关键词提升店铺曝光?

- 拼多多自定义如何删除关键词?删除自定义关键词的步骤是什么?

- 如何优化SEO搜索结果?SEO搜索优化有哪些技巧?

- 如何提高百度优化关键词排名?

- 高端网站设计如何体现企业形象?

- 搜索引擎优化排名seo的技巧有哪些?

- 淘宝关键词推广设置的步骤是什么?

- 网站关键词优化工具怎么用?优化效果如何评估?

- 如何自己创建网站?需要哪些步骤和工具?

- SEO怎么做才能有效果?

- 关键词优化seo的步骤是什么?

- 小红书关键词搜索无结果怎么办?

- 建网站网站建设需要注意什么?如何进行网站建设?

- 网站关键词排名如何优化?优化网站关键词排名的策略是什么?

- 网站推广方式有哪些?哪种更适合初创企业?

- 热门tag