深入探究网站的robots.txt文件

![]() 游客

2024-03-31 13:56:01

79

游客

2024-03-31 13:56:01

79

但是你真的了解它的作用和规则吗,在网站开发过程中、txt这个词语、我们经常会听到robots?txt文件,让您更好地掌握这个重要的SEO工具,在本文中、我们将为您深入探究robots。

一、什么是robots.txt文件?

哪些页面不应被索引,txt文件是一个文本文件,robots,主要用于告诉搜索引擎哪些页面可以被索引。并且遵守一些特定的语法和规则,它位于网站根目录下。

二、txt文件,为什么需要robots?

可以控制搜索引擎爬虫的访问频率,从而保障网站运行的稳定性、并且避免不必要的资源浪费,创建robots,txt文件可以让网站管理员更好地管理搜索引擎对网站内容的访问。

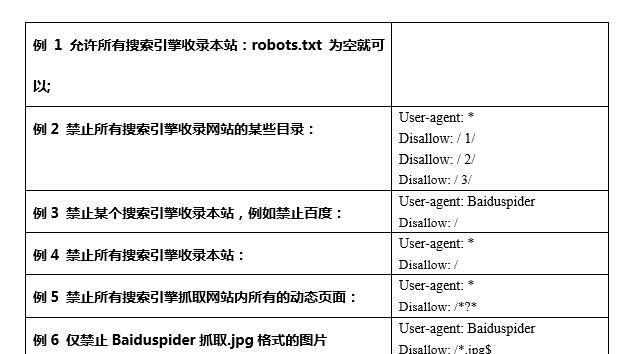

三、txt文件有哪些规则、robots?

1.User-agent:表示要被指定的爬虫(如Googlebot)。

2.Disallow:表示禁止爬虫访问的文件或目录。

3.Allow:表示允许爬虫访问的文件或目录。

4.Crawl-delay:表示爬虫访问网站的时间间隔。

四、txt文件,怎样正确地编写robots?

1.不要过度限制搜索引擎的访问。

2.不要向搜索引擎索取快速索引。

3.txt中,不要将敏感信息暴露在robots。

4.txt中,不要将无关内容放在robots。

五、txt文件有哪些常见错误、robots?

1.错误的语法和格式。

2.禁止了所有搜索引擎对网站进行访问。

3.使用禁止某些搜索引擎访问的规则。

六、txt文件是否有效,如何检查robots?

可以通过使用GoogleWebmasterTools等工具进行检查。则应该及时修改,以保证搜索引擎可以正常索引您的网站内容、如果存在错误。

七、txt文件能否完全阻止搜索引擎,robots?

但不能完全阻止搜索引擎对网站内容的索引,robots,txt文件只能控制搜索引擎访问某些页面的频率和方式。可以使用noindex元标签等技术手段、如果您希望防止某些页面被索引。

八、txt文件提升SEO效果,如何利用robots?

1.如登录,注册页面等、禁止不必要的页面被索引。

2.避免服务器过载,限制搜索引擎对某些目录或文件的访问频率。

3.指定Sitemap以便搜索引擎更好地索引您网站内容。

合理地编写和使用该文件,通过深入了解robots、我们可以更好地掌握它的作用和规则,txt文件、从而达到优化SEO效果和防范安全风险的目的。txt文件是SEO优化成功的重要一步,同时,需要注意的是、编写一个有效的robots。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自火星seo,本文标题:《深入探究网站的robots.txt文件》

标签:SEO技术

- 上一篇: 如何取消抖音达人主题(轻松操作)

- 下一篇: 如何通过抖音上商家链接来实现营销(掌握抖音营销技巧)

- 搜索

- 最新文章

- 热门文章

-

- 小红书优惠券叠加攻略(教你如何最大化使用小红书优惠券)

- 小红书一万播放量多少钱(了解小红书播放量计费规则)

- 小红书出台新规定,用户行为需符合社区准则(小红书新规定要求用户规范行为)

- 小红书的价值(探究小红书的商业价值)

- 如何优化移动端SEO,让你的流量倍增(掌握15个技巧)

- 整站优化小技巧,助力网站爆红(15个实用技巧)

- 小红书是否支持一个号同时登陆两个手机(解决你的小红书跨设备登陆难题)

- 做SEO优化多久才能见效(探究SEO优化的时间成本和效果)

- 如何通过关注百度搜索和下拉框来优化SEO(掌握竞争)

- 网站建设的流程与注意事项(从规划到上线)

- 如何做好快手短视频选题(15个段落)

- 如何提高网站排名(掌握优化技巧)

- 快手短剧剧星计划政策详解(政策内容)

- 小红书推广方式,引流新思路(掌握新方法)

- 小红书引流违规,如何防范(规范营销行为)

- 提高蜘蛛爬行频率的两点方法(做好网站架构与内容优化)

- 如何将自己的店铺设置为快手定位主题(简单设置)

- 一、了解靠前关键词的意义

- 快手顶级流量是多少(了解快手顶级流量的真实数据及背后的含义)

- 如何提高快手短视频流量池(教你如何让视频得到更多曝光)

- 热门tag